Nous nous retrouvons dans les locaux de notre partenaire TSF le 27 avril 2023 pour notre troisième session de récolte de métadonnées optiques (MDO).

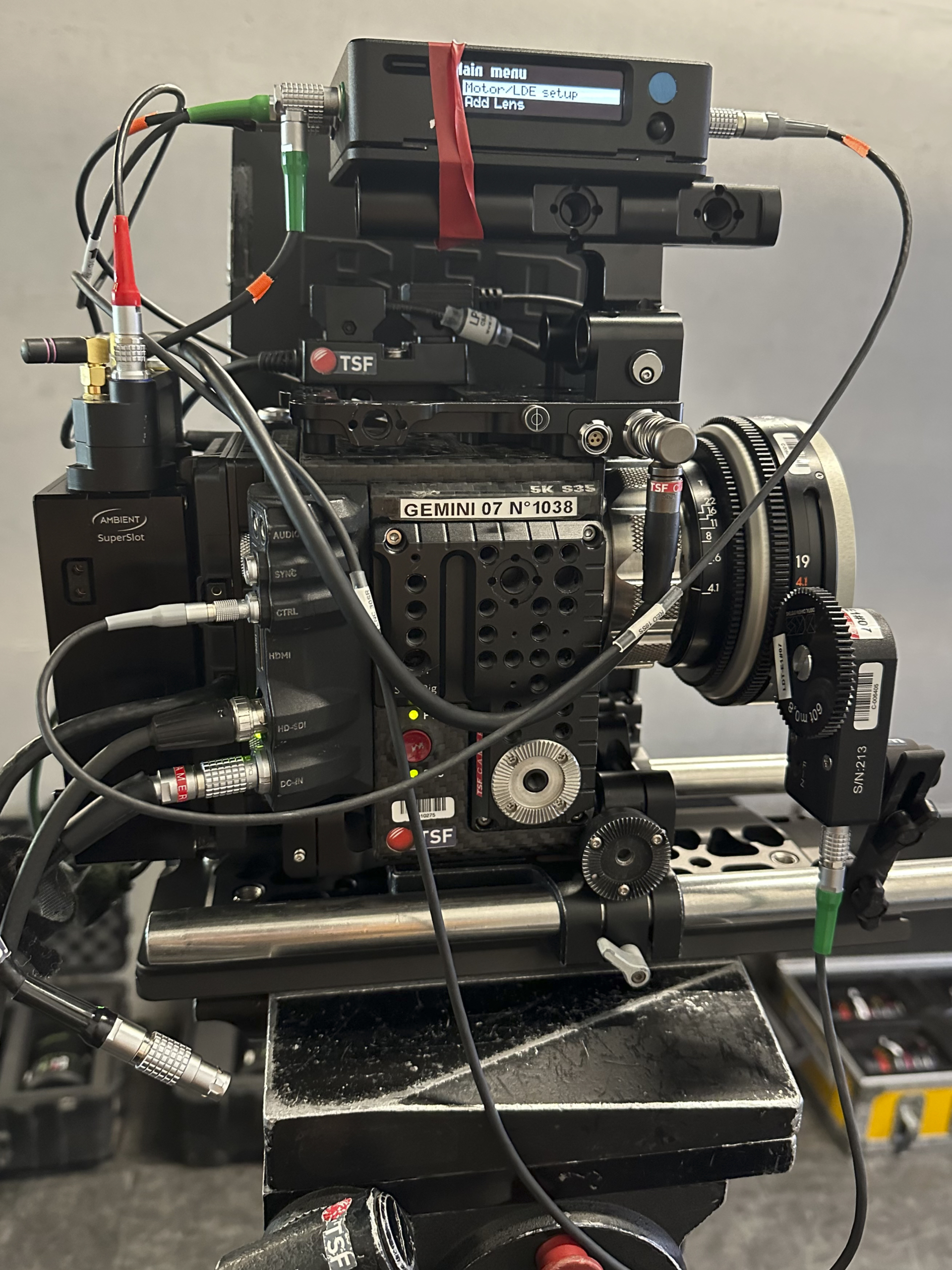

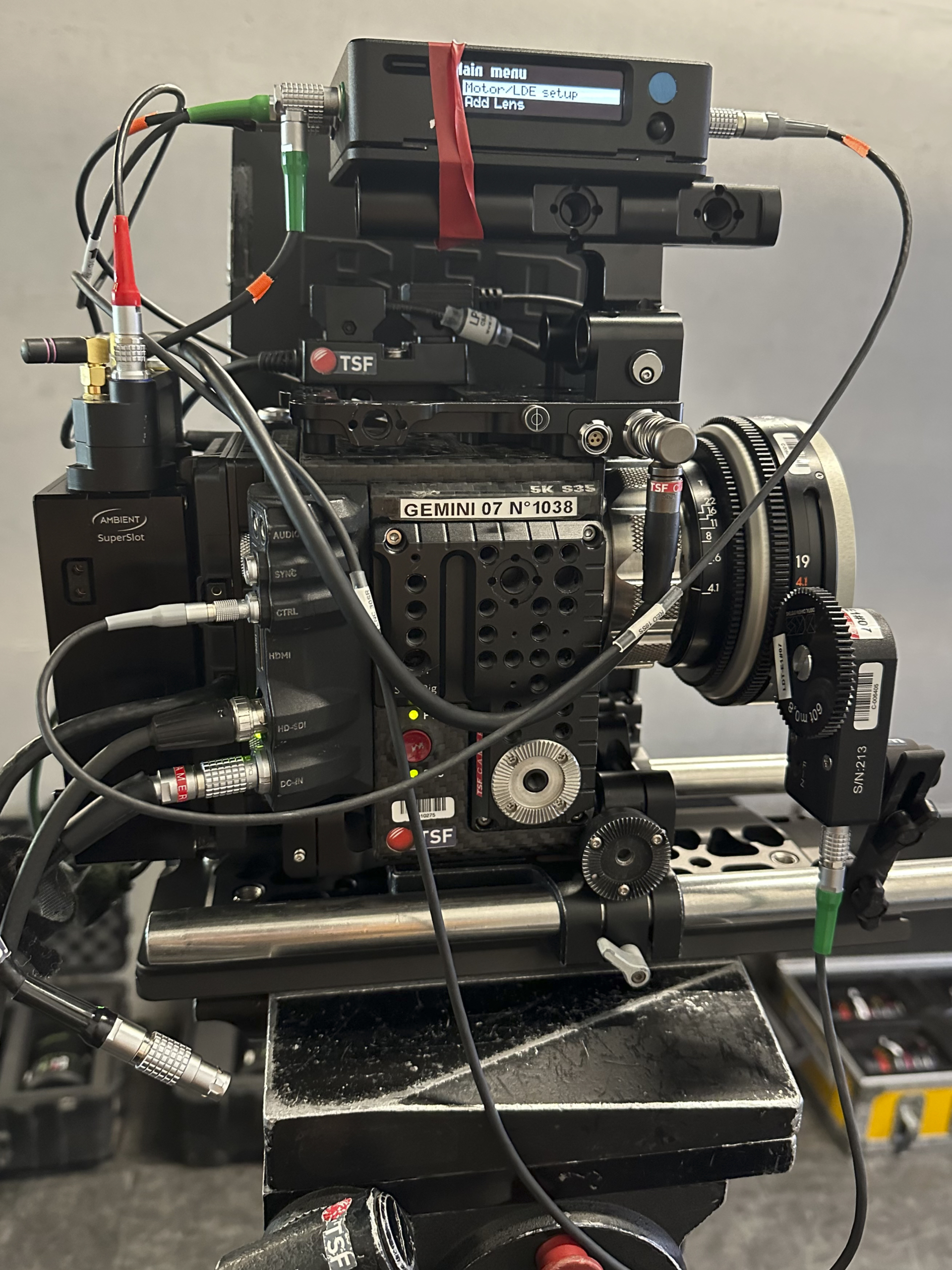

Thomas Bataille, Valentine Lequet et Grégoire Ausina / Banc d’essai TSF

Dans le cadre de notre étude technique, qui s’étend de la prise de vues à la post-production, nous intégrons une variété d’optiques et de corps caméra. Certaines de ces optiques peuvent générer des métadonnées, mais cela nécessite une compatibilité avec plusieurs éléments : les montures, les câbles, les boitiers lecteurs de LDA, et les générateurs de timecode. Assurer cette compatibilité est un point critique de nos tests. En outre, il est essentiel de vérifier que les loueurs disposent bien de tous les équipements nécessaires.

Pour prolonger les essais et tenter de dépasser notre premier échec avec le boitier LDT-R2 de DCS, TSF a mis à notre disposition une série de Kowa Vintage FF sphériques ainsi qu’une RED Gemini 5K DMSC2.

L’objectif est ici de voir s’il est possible d’inscrire des métadonnées optiques de type FIZ (donc les métadonnées primaires de type Focus/Iris/Zoom) dans les fichiers image de la caméra. Nous devons trouver comment produire ces métadonnées à partir de ces optiques vintage qui sont totalement dépourvues d’électronique.

Pour ce faire nous devrons utiliser la roue codeuse LDT-E1 associée au boitier LDT-R2.

Description et réglage du dispositif

Fidèles à notre protocole, nous passons un 19mm (T4.1), la caméra positionnée face à une mire de déformation.

Le boitier Ambient Lockit+ est alimenté via le port V-Lock de la caméra.

Le port TC out du Lockit+ est connecté au TC in du boitier LDT-R2

Le port CAM du LDT-R2 est connecté au port CTRL de la Gemini

L’encodeur LDT-E1 (out) est relié au port ENC (in) du LDT-R2

Le port PWR du LDt-R2 est alimenté via DTAP.

Dans le menu caméra de la Gemini: Settings > setup > communication > serial (ctrl protocol = element technical).

Dans le menu du boitier Lockit+: Cam port en RED-ET, Serial port en DCS-IO, DCS protocole (RAW encoder enabled, tilt roll enabled).

Enfin nous ajoutons un moteur C-Force mini RF ainsi qu’une commande Hi-5.

Côté réglages caméra, nous choisissons un iso à 800, en 25 fps, capteur 5K ratio 1.7:1 et rec en RAW 8:1

Un test concluant

Consulter les documentations constructeur, récupérer les câbles nécessaires, comprendre et faire le choix des réglages dans la caméra et les boitiers, tout cela prend un certain temps… Sans disposer de LDA pour la série Kowa, nous devons en outre créer une LDA manuellement, au moins pour l’optique choisie pour nos tests (à multiplier avec toutes les focales de la série !).

Après un premier enregistrement qui ne semble pas concluant, nous modifions un ultime paramètre dans le menu de la Gemini : Settings > Setup > Lens (désactiver “Enable power to Lens” et “Auto Detect PL Lenses” – nous devons alors recalibrer la roue encodeuse LDT-E1). Nouvel enregistrement incluant une bascule de point.

Après vérification sur un ordinateur via le RED Player, les MDO apparaissent bien dans le fichier RAW R3D, incluant la focale, la distance focale et les variations résultant de la balance de point !

Il faut noter qu’apparaissent également les données de tilt et roll issues non pas de l’optique ou de la caméra mais du boitier LDT-R2, qui a la capacité de générer des données gyroscopiques.

Nous avons vu qu’avec la Sony Venice 2, le LDT-R2 n’est pas encore pleinement opérationnel (il manquerait la fameuse « specialist mount » tandis qu’avec une caméra Arri, le LDT-R2 n’est pas opérant, le boitier Ambient Lockit+ et l’UMC-4 d’Arri étant complémentaires dans le cas où toutes les informations ne pourraient pas être inscrites dans les fichiers image via la monture PL/LPL

En revanche, dans un écosystème RED il pourrait s’avérer être un vrai plus.

Et après ?

À l’issue de cette phase de tests divers, plusieurs reflexions :

- Ces configurations nécessitent un temps particulièrement long pour vérifier la chaine des données de bout en bout. Sachant que pour le moment, nous nous sommes contentés de vérifier la présence des métadonnées que nous avons tournées. La prochaine étape nous amènera en post-prod à évaluer quelques plans pour comparer les distances réelles avec les solutions de track 3D. Mais on peut raisonnablement imaginer qu’en production le temps des essais et les incertitudes sur la faisabilité technique doivent être compliqués à gérer.

- Les dispositifs (protocole, boitiers, « specialist mount ») sont en cours de développement et nécessitent parfois un support technique en direct avec les concepteurs. En effet, on pousse les systèmes à leurs limites et il faut parfois trouver de l’aide auprès des experts, et les manuels en ligne ne sont pas toujours à jour.

- Nous avons vu qu’il est possible d’assigner des métadonnées à des optiques qui en sont intrinsèquement dépourvues, mais cela demande un effort conséquent pour un résultat bien moins riche et précis qu’avec des optiques électroniques « modernes ».

Autrement dit, l’utilisation d’optiques vintage sur des films nécessitant des VFX est un petit défi technique qui devrait vraiment se justifier artistiquement, surtout quand on voit arriver des systèmes clés en main développés par certains constructeurs. - La prochaine étape de ce travail se fera en post-production, afin de démontrer l’utilité des MDO avec nos médias. L’idée est notamment d’expliquer le principe du tracking 3D (comme solution calculée du mouvement de la caméra virtuelle dans l’espace) pour comprendre le bénéfice que peut représenter un tracking live (position physique de la caméra mesurée pour créer la caméra virtuelle) avec des dispositifs comme Cincraft Scenario dont la version 2 vient tout juste de sortir chez Zeiss ou Eztrack avec qui Cooke a créé un partenariat.

Avec des équipements en actuellement en développement constant, cette étude dédiée aux MDO laisse donc entrevoir d’autres sessions à venir. Nous nous en ferons sans aucun doute l’écho.

Merci à Valentine Lequet coprésidente de l’UCO, Sarah Guillaumin Haddad, Charlotte Michel, Sara Cornu, Thomas Bataille.

Un grand merci à toute l’équipe de TSF pour leur accueil et leur implication.

____

🇬🇧 English version

Optical metadata #4: LDT-R2 + RED = metadata within R3D!

We’re meeting at our partner TSF‘s premises on April, 27th ’23 for our third lens metadata (LD) harvesting session.

Thomas Bataille-Valentine Lequet-Grégoire Ausina / Camera test bench TSF

As part of our technical study, which extends from shooting to post-production, we are including a variety of lenses and camera bodies. Some of these lenses can generate metadata, but this requires compatibility with several elements : mounts, cables, LDA reader boxes and timecode generators. Ensuring this compatibility is a critical point in our tests. In addition, it is essential to check that the rental companies have all the necessary equipment.

To extend the tests and try to overcome our first failure with the DCS LDT-R2, TSF provided us with a series of spherical Kowa Vintage FFs and a RED Gemini 5K DMSC2.

The aim here is to see if it is possible to write FIZ lens metadata (i.e. primary Focus/Iris/Zoom metadata) in the camera’s image files. We need to find out how to produce this metadata from these vintage lenses, which have no electronics whatsoever.

To achieve this, we will need to use the LDT-E1 encoder associated with the LDT-R2 housing.

Setting up

Following our protocol, we used a 19mm (T4.1), we shoot a lens deformation grid.

The Ambient Lockit+ is powered via the camera’s V-Lock port.

The TC out port ofthe Lockit+ is connected to the TC in port of the LDT-R2.

The LDT-R2 CAM port is connected to the Gemini CTRL port.

The LDT-E1 encoder (out) is connected to the LDT-R2 ENC port (in)

The PWR port of the LDT-R2 is powered via DTAP.

In the Gemini camera menu: Settings > setup > communication > serial (ctrl protocol = element technical).

In the Lockit+ box menu: Cam port in RED-ET, Serial port in DCS-IO, DCS protocol (RAW encoder enabled, tilt roll enabled).

Finally, we added a C-Force mini RF motor and a Hi-5 remote.

In terms of camera settings, we chose an iso of 800, 25 fps, 5K sensor ratio 1.7:1 and rec in RAW 8:1.

A conclusive test

Consulting the manufacturer’s documentation, collecting the necessary cables, understanding and choosing the settings in the camera and the housings, all this takes a certain amount of time… As we don’t have any LDA for the Kowa series, we also have to create an LDA manually, at least for the lens chosen for our tests (to be repeated with all the focal lengths in the series !).

After an initial recording that didn’t seem successful, we modified a final parameter in the Gemini menu: Settings > Setup > Lens (deactivate ‘Enable power to Lens’ and ‘Auto Detect PL Lenses’ – we then had to recalibrate the LDT-E1 encoder wheel). New recording of a focus rack shot.

After checking on a computer using RED Player, the metadata do appear in the R3D RAW file, including the focal length, focal distance and variations resulting from the focus shift !

It should be noted that tilt and roll data also appear, not from the lens or camera but from the LDT-R2 box himself, which has the ability to generate gyroscopic data.

We have seen that with the Sony Venice 2, the LDT-R2 is not yet fully operational (it lacks the famous ‘specialist mount’), while with an Arri camera, the LDT-R2 is not operational, the Ambient Lockit+ and Arri’s UMC-4 being complementary in the event that not all the information can be recorded in the image files via the PL/LPL mount.

In a RED ecosystem, however, it could prove to be a real added value.

What next?

Several reflexions conclude these various test phases :

- These configurations require a particularly long time to check the end-to-end data chain. For the moment, we’ve confined ourselves to checking the presence of the metadata we shot. The next stage will see us evaluating a few shots in post-production to compare actual distances with 3D track solutions. But it’s reasonable to imagine that in production, the testing time and uncertainties about technical feasibility must be difficult to manage.

- The devices (protocol, boxes, specialist mount) are still under development and sometimes require direct technical support from the designers. The systems are being pushed to their limits and it is sometimes necessary to seek help from the experts, and the online manuals are not always up to date.

- We have seen that it is possible to assign metadata to lenses that are intrinsically deprived of it, but this requires a considerable effort for a much less rich and precise result than with ‘modern’ electronic lenses.

In other words, using vintage lenses on films requiring VFX is a fairly technical challenge that should really be justified artistically, especially when we see the arrival of turnkey systems developed by certain manufacturers.Translated with www.DeepL.com/Translator (free version) - The next stage of this work will be in post-production, to demonstrate the usefulness of metadata with our media. The idea is to explain the principle of 3D tracking (as a calculated solution to the movement of the virtual camera in space) in order to understand the potential benefits of live tracking (physical position of the camera measured to create the virtual camera) with devices such as Cincraft Scenario, version 2 of which has just been released by Zeiss, or Eztrack, with which Cooke has formed a partnership.With equipment that is currently undergoing constant development, this study dedicated to metadata gives us a glimpse of other sessions to come. We’ll be sure to keep you posted.

Many thanks to Valentine Lequet, co-president of UCO, Sarah Guillaumin Haddad, Charlotte Michel, Sara Cornu and Thomas Bataille.

A big thank you to the TSF team for their warm welcome and commitment.

-

Partager l'article